Investir les robots logiciels d’une mission

- UdeMNouvelles

Le 28 mars 2023

- Jeff Heinrich

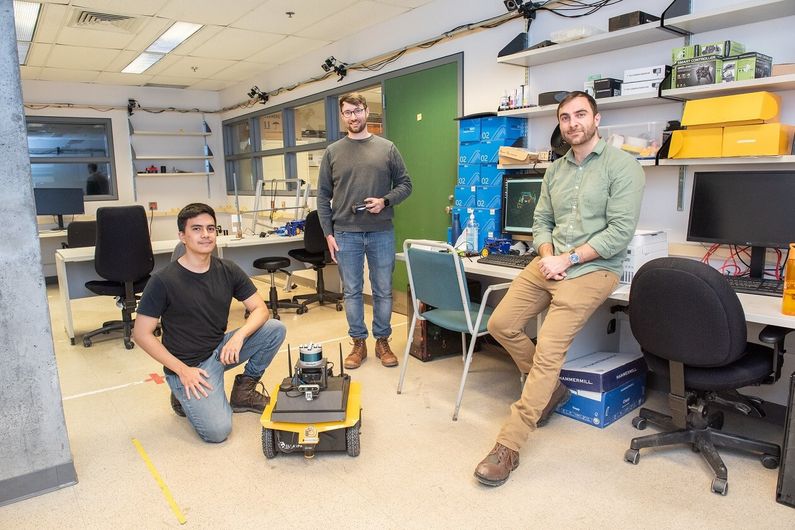

Miguel Saavebra, étudiant de maîtrise, Steven Parkison, étudiant au postdoctorat, et Glen Berseth, professeur adjoint au Département d’informatique et de recherche opérationnelle de l'UdeM, membre de Mila ‒ l’Institut québécois d’intelligence artificielle ‒ et codirecteur du Robotics and Embodied AI Lab du département

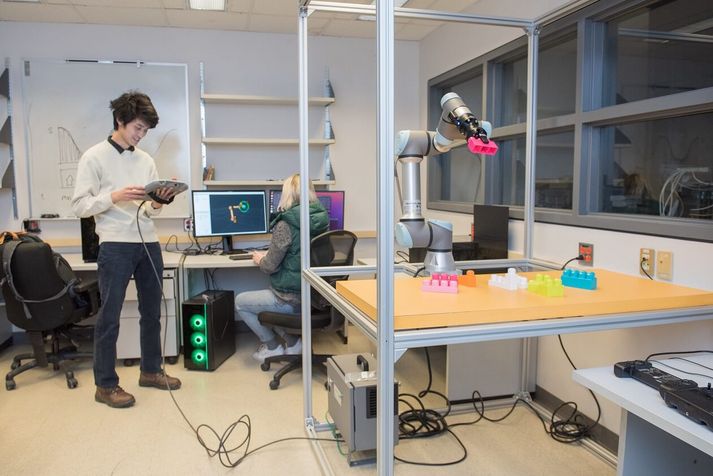

Crédit : Amélie Philibert | Université de MontréalAu Département d’informatique et de recherche opérationnelle de l’UdeM, Glen Berseth et ses étudiants s’affairent à mettre à l’épreuve deux bras robotisés, un quadrupède et un camion-jouet motorisé.

Dans un laboratoire d’informatique de l’Université de Montréal, Glen Berseth et ses étudiants et étudiantes des 2e et 3e cycles font fonctionner trois types de robots.

Un groupe de bras robotisés s’affaire à assembler des structures au moyen d’un jeu de blocs ainsi qu’à nettoyer et à plier du linge à l’intérieur d’une «cage» ouverte façonnée de barres d’aluminium.

Pourvu de son propre bras lui permettant de pousser des objets dans la pièce, un quadrupède se déplace sur le sol, comme un chien s’amusant à pousser de petits objets avec sa patte.

Enfin, un véhicule à quatre roues, qui ressemble à un camion Tonka jaune surdimensionné, se déplace à l’aide de caméras installées à l’avant et à l’arrière de celui-ci, une tour pourvue de capteurs étant fixée sur son toit.

Grâce à l’intelligence artificielle (IA), ces trois types de robots sont entraînés à reconnaître les tâches qu’on leur demande d’exécuter de telle sorte qu’un jour ils pourront être mis à profit de manière pratique dans nos foyers, où ils seront appelés, par exemple, à plier le linge ou à préparer le petit déjeuner.

Choisir avec soin, puis concevoir

«La première étape a consisté à faire l’acquisition du matériel de robotique et à choisir les pièces avec soin. Aujourd’hui, nous en sommes à l’étape de la conception des tâches que les robots vont apprendre, a expliqué Glen Berseth, professeur adjoint au Département d’informatique et de recherche opérationnelle de l'UdeM, membre de Mila – l’Institut québécois d’intelligence artificielle – et codirecteur du Robotics and Embodied AI Lab du département. Si nous avons bel et bien les robots, comment pouvons-nous nous y prendre pour leur faire comprendre qu’ils ont accompli du bon travail et qu’ils font ce que nous souhaitons qu’ils fassent?»

Ainsi, l’un des bras robotisés «est équipé de caméras pour le guider, mais, graduellement, nous aurons recours à l’IA pour l’entraîner à reconnaître ce qu’il doit faire. En premier lieu, il verra des photos de linge plié, puis il essaiera de plier le linge lui-même, et ce n’est qu’une fois qu’il sera parvenu à bien se tirer d’affaire qu’il obtiendra un “sucre” numérique de notre part – sous la forme d’un 1 plutôt que d’un 0 – de manière que ce comportement approprié puisse être renforcé, faisant en sorte qu’il sera plus susceptible d’accomplir cette tâche avec succès à la prochaine occasion. Par la suite, nous répéterons cette opération avec toutes sortes de pièces de linge», dit le chercheur.

En revanche, l’autre bras est entraîné pour déplacer des objets sur une table, quelle que soit la couleur de cette dernière. «En d’autres termes, le bras est entraîné pour faire abstraction de la couleur de la surface», indique Glen Berseth. Pour sa part, le quadrupède est amené à se déplacer «dans des endroits comme à Montréal, où les appartements ne sont pas toujours au niveau du sol, où il y a des marches et où, à l’extérieur, abondent les nids-de-poule dans les rues une fois le printemps venu», ajoute-t-il.

Glen Berseth et ses étudiants et étudiantes ont assemblé les robots de telle sorte qu’ils soient polyvalents, pouvant de cette façon accomplir bien plus que les tâches pour lesquelles ils ont été conçus, comme déplacer des produits et les poser sur une étagère dans un entrepôt. Ils veulent que ces machines soient en mesure de «voir» l’espace dans lequel elles se trouvent et qu’elles agissent en conséquence.

Comme l’a souligné Glen Berseth: «À l’heure actuelle, les robots n’utilisent pas véritablement les données captées par l’entremise de la caméra. Ainsi, sur une chaîne de montage automobile, les robots sont pour l’essentiel aveugles et répètent avec précision les tâches qu’on leur confie, sans jamais commettre d’erreur. Mais telle n’est pas la façon dont notre monde fonctionne vraiment. Nous aimerions que les robots soient en mesure de faire beaucoup plus afin de tirer véritablement parti de l’information qu’ils recueillent. Nous voulons que le robot réagisse de la même manière que les humains.»

Douze étudiants diplômés au travail

Dans les laboratoires du Département d’informatique et de recherche opérationnelle, situés au troisième étage du pavillon André-Aisenstadt, six étudiants et étudiantes des 2e et 3e cycles de Glen Berseth travaillent sur les robots (trois sur les bras robotisés et trois sur le véhicule), tandis que six autres s’intéressent à l’apprentissage par renforcement. Le jour de notre visite, Kirsty Ellis, ingénieure en logiciels de robotique, était à l’ordinateur, contrôlant l’un des bras robotisés à l’aide d’un logiciel de planification et l’aidant à déplacer des pièces d'un jeu de blocs en plastique vers différentes «positions cibles» à l’intérieur de la cage. Pour sa part, le doctorant de première année Albert Zhan se tenait à proximité, muni d’une console d’alimentation portative, s’employant à surveiller les mouvements du bras.

L’équipe travaille également à une version qui pourra être utilisée à la maison. Par exemple, Albert Zhan espère cuisiner avec l’un de ces robots: «Je n’entrevois rien de compliqué; peut-être pourrait-il faire des œufs brouillés, dit-il, ou verser dans la casserole des portions prémesurées en vue de les faire cuire.» Pendant ce temps, dans un laboratoire voisin, Miguel Saavebra, étudiant de maîtrise, et Steven Parkison, étudiant au postdoctorat, s’apprêtent à mettre à l’épreuve le camion robotisé en tentant de déterminer comment il peut parvenir à se déplacer de manière optimale dans la pièce.

«Nous lui donnons une image de quelque chose et il se dirige vers cette chose en ne s’appuyant que sur cette information, explique Miguel Saavebra, qui se prépare à présenter son projet de thèse à Detroit, à la conférence annuelle IROS sur l’intelligence robotique. Sur l’un des écrans d’ordinateur, vous voyez une représentation tridimensionnelle en direct de la pièce saisie par les capteurs, tandis que, sur l’autre, s’affichent des représentations du “monde physique” obtenues par le truchement des caméras. À l’aide de ces deux outils, nous pouvons évaluer dans quelle mesure la partie relevant de l’apprentissage automatique du test fonctionne tout en déterminant si le robot pose les gestes que nous souhaitons qu’il pose.»

Mémoire hors ligne pour enrichir les connaissances

Les robots de l’UdeM «conservent une bonne partie de mémoire hors ligne, souligne Glen Berseth. Ils disposent d’une image de ce qu’ils ont fait auparavant et de ce à quoi cela ressemble de telle sorte qu’ils feront des gestes analogues à ceux qui se trouvent déjà dans leur base de données. Nous faisons actuellement appel à l’apprentissage automatique pour passer à l’étape suivante, qui consiste à verser toute cette information dans un modèle où les machines apprennent plutôt que de simplement passer en revue une séquence d’images. Les machines n’ont pas à chercher dans leur base de données, puisque cette information est déjà intégrée au modèle».

Dès son arrivée au laboratoire, le camion à quatre roues était en mesure de se déplacer à l’aide des capteurs dont il était pourvu, «mais nous souhaitons qu’il soit également capable de se déplacer en s’appuyant sur les images que nous lui communiquons, situation qui ressemblerait plus à ce qui prévaut dans le monde réel – et grâce à l’IA, il devrait être en mesure d’y parvenir», mentionne Miguel Saavebra. Et Glen Berseth d’ajouter: «Nous voulons que cela soit un peu plus convivial. Pour le moment, la communication sous forme de texte commence à devenir utile, même s’il faut taper quelque chose, cependant que l’audio s’avère plus délicat. En effet, les pauses sont multiples et chaque personne a un ton de voix différent.»

Miguel Saavebra conclut en riant: «À terme, j’aimerais pouvoir équiper le robot d’une paire de bras et de jambes afin qu’il puisse laver la vaisselle pour moi, accomplir des tâches de cette nature. En d’autres termes, les tâches ennuyeuses!»